HMoE是什么

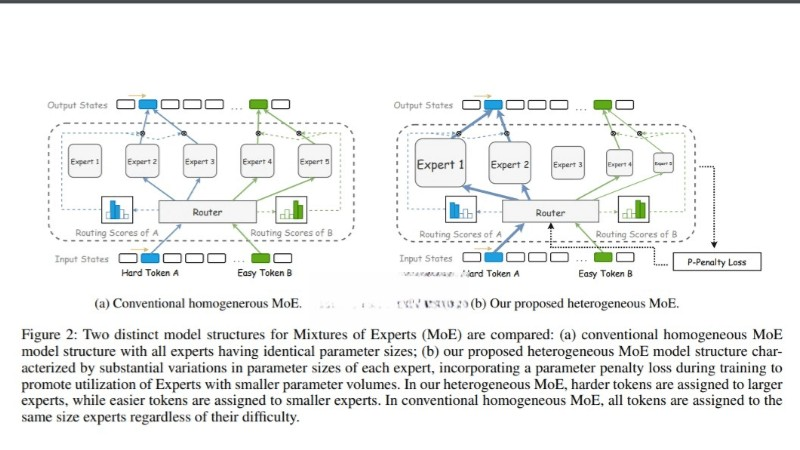

HMoE(混合异构专家模型)是腾讯混元团队提出的新型神经网络架构,旨在提升大型语言模型的性能和计算效率。通过引入不同尺寸的专家来处理不同复杂性的输入数据,从而增强模型的专业化程度。HMoE采用新的训练目标和策略,如P-Penalty Loss,鼓励频繁激活更小的专家,以提高参数利用率和计算效率。实验证明,HMoE在多个预训练评估基准上性能卓越,为大模型研究提供了新方向。

HMoE的功能特色

- 异构专家设计:HMoE模型中的专家尺寸不一,能根据输入数据的复杂性分配不同能力的专家进行处理,提高模型的专业化和灵活性。

- 计算效率优化:通过激活更小的专家来处理简单任务,HMoE在保持高效计算的同时,能将计算资源集中于更复杂的任务。

- 参数利用效率:HMoE通过P-Penalty Loss等训练策略,优化了参数的分配和激活,减少了对大型专家的依赖,提升了模型整体的参数使用效率。

- 动态路由策略:结合Top-P和Top-K路由策略,HMoE能根据每个token的重要性动态地激活相应数量的专家,实现更加精细化的模型控制。

- 性能提升:在多个预训练评估基准上,HMoE展现出超越传统同质MoE模型的性能,证明在处理复杂语言任务上的有效性。

HMoE的技术原理

- 异构专家结构:HMoE模型由多个不同尺寸的专家组成,每个专家都是一个独立的神经网络,能处理输入数据的不同方面。允许模型根据任务的复杂性动态分配计算资源。

- 路由机制:HMoE使用路由策略(如Top-K和Top-P路由)来决定哪些专家将被激活以处理特定的输入。Top-K路由固定激活K个专家,而Top-P路由根据概率阈值动态确定激活专家的数量。

- 参数化损失函数:为了解决专家激活不平衡的问题,HMoE引入了参数化损失函数(P-Penalty Loss),该损失函数根据专家的尺寸调整其在总损失中的权重,鼓励模型更多地激活小型专家。

- 训练目标优化:HMoE通过优化训练目标,不仅考虑模型性能,还考虑参数的高效利用。通过结合语言模型损失、P-Penalty Loss和路由器熵损失(Lentropy)来实现。

HMoE的项目地址

- arXiv技术论文:https://arxiv.org/pdf/2408.10681

HMoE的应用场景

- 自然语言处理(NLP):HMoE可以应用于机器翻译、文本摘要、情感分析、文本分类、问答系统等NLP任务,基于异构专家处理不同语言特性的能力。

- 内容推荐系统:在推荐系统中,HMoE可以分析用户行为和偏好,提供个性化的内容推荐。

- 语音识别:HMoE可以应用于语音识别技术,处理不同说话者的特征和语音中的复杂信息。

- 图像和视频分析:虽然HMoE主要设计用于处理语言模型,但其异构专家的概念也可以扩展到图像和视频分析领域,处理视觉数据的不同方面。

- 多模态学习:在处理结合文本、图像和声音等多种数据类型的任务时,HMoE可以有效地分配专家处理不同模态的数据。

© 版权声明

本站文章版权归AI365导航网所有,未经允许禁止任何形式的转载。